Le tecnologie digitali stanno profondamente cambiando il mondo della musica. Molte competenze sono diventate obsolete e nuovi talenti stanno emergendo. Ma quale sarà in futuro il ruolo dell’artista?

di Gadi Sassoon

Dagli anni ’90 a oggi la rivoluzione digitale ha stravolto le fondamenta stesse del business della musica: distribuzione e vendita di supporti fonografici sono state sostituite da servizi streaming; parallelamente, i musicisti hanno abbracciato i social per interagire direttamente coi fan. Questi cambiamenti sono evidenti a chiunque consumi musica in questi anni.

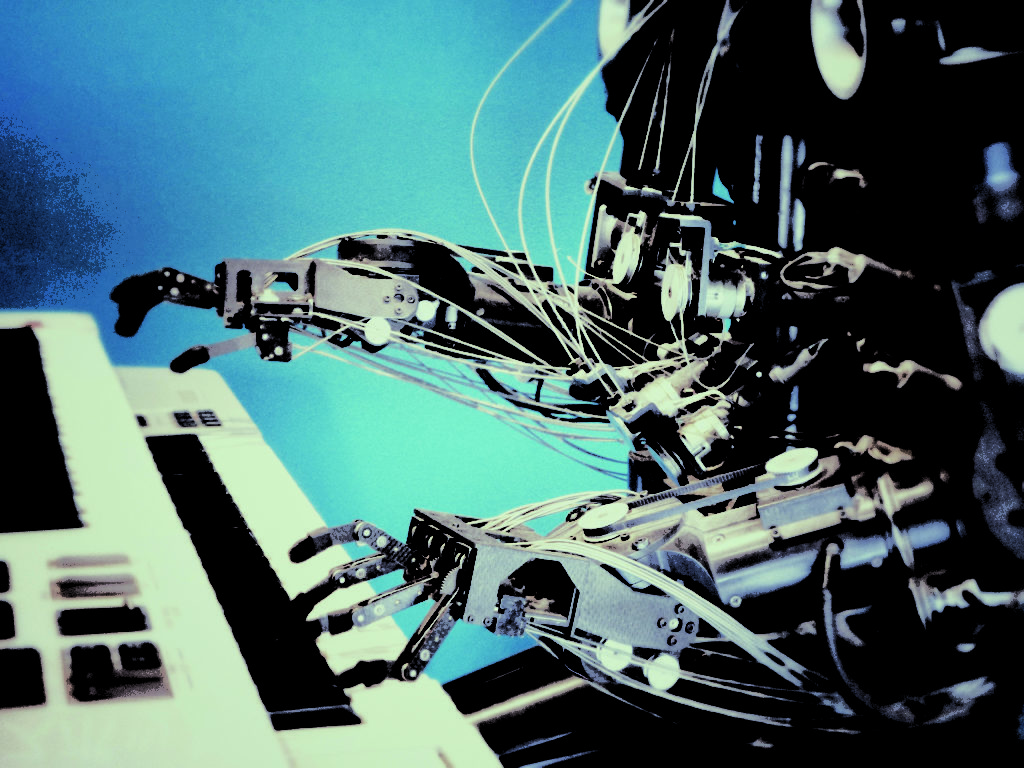

Esiste però un lato meno scontato di questa trasformazione: la digitalizzazione di produzione e composizione musicali. Gli studi di registrazione con attrezzature milionarie sono stati rimpiazzati da programmi per laptop, tablet e smartphone, mettendo in mano a milioni di persone mezzi un tempo inaccessibili; in ambito professionale, persino le orchestre devono competere con software che permettono al compositore-programmatore di creare credibilmente intere sinfonie.

Questo aspetto della digitalizzazione della musica ha profondamente cambiato la struttura interna dell’industria, rendendo molte competenze obsolete e facendo emergere nuove forme di talent. Oggi, con l’avvento dell’intelligenza artificiale, dobbiamo prepararci alla prossima tappa della nostra evoluzione.

In un contesto in cui la produzione artistica é già di fatto informatizzata, il machine learning é efficace anche in ambiti finora legati a capacità esclusivamente umane: é l’inizio di un fenomeno che potremmo chiamare l’automazione della creatività. Oltre alle applicazioni musicali dimostrative di potenti AI generaliste come IBM Watson, stiamo già assistendo all’utilizzo commerciale di AI specializzate in grado di fare cose molto sofisticate – comporre, finalizzare un mix, inventarsi una base – più velocemente e a costo infimo rispetto a una controparte umana, con risultati sorprendenti.

Alcuni servizi eliminano l’intervento di un compositore umano per creare musica: Aiva (Artificial Intelligence Virtual Artist) é un’azienda la cui AI compone “colonne sonore emotive” tramite un portale web; Amper Music offre “strumenti intuitivi per non-musicisti” che grazie alla loro AI musicale “generano musica rapidamente nello stile, durata e struttura” che il cliente desidera – eliminando il problema del diritto d’autore. Altre aziende applicano il machine learning all’ambito dell’audio engineering: Izotope mette a disposizione di ingegneri del suono professionisti e amatoriali strumenti AI per la produzione e l’analisi di un brano, mentre Landr offre un servizio online di mastering (il lavoro iper specialistico di “far suonare” un brano per andare in radio, in tv, su un disco) basato su machine learning.

Nel frattempo una nuova categoria di “music hacker” esplora frontiere più avventurose: il ricercatore indipendente CJ Carr ha scoperto ad esempio che modificando gli algoritmi di machine learning Lyrebird, inventati per creare voci artificiali iper-realistiche, può creare reti neurali capaci di produrre stili musicali estremamente specifici. Ne é nata l’intelligenza artificiale Dadabot, che crea interi album autonomamente. Il musicista britannico Reeps One, il collaborazione con Nokia Bell Labs, ha usato Dadabot per un duetto con una copia virtuale di sé stesso capace di formulare idee musicali originali. E questi sono solo alcuni esempi di un campo in continua crescita, nel quale si sente già parlare di “esseri virtuali”.

La domanda che come compositori, artisti, produttori dobbiamo porci é: come risponderemo all’automazione di quella creatività dalla quale dipendono le nostre figure professionali? Se ci baseremo su formule consolidate, sarà sempre più probabile che una macchina intelligente ci sostituisca, o che per lo meno renda obsolete capacità che abbiamo costruito con fatica.

La sfida sarà evolvere in due direzioni parallele: da un lato, diventare stilisticamente unici ed eccezionalmente competenti, dall’altro capire come usare questi nuovi strumenti per potenziare la nostra creatività ed esplorare nuove frontiere. Forse il ruolo futuro dell’artista umano sarà concentrarsi sulle emozioni, lasciando alle macchine il lavoro realizzativo. Ma la risposta a queste domande non é scontata.

Quando si parla di AI driven disruption, nei dibattiti si incontrano spesso gli stessi esempi: camion a guida autonoma, consegne con droni, automazione di lavoro manuale. Ma l’automazione della creatività é già qui, e saranno coloro che sanno vedere oltre il codice a raccogliere i frutti della prossima rivoluzione.

Per parafrasare Reeps One, “per vedere più lontano, dovremo essere come nani sulle spalle dei robot”.

Gadi Sassoon è compositore e produttore. Opera tra Milano, Londra e Los Angeles. Il suo lavoro appare su Warner, Ninja Tune, NBC Universal, BBC, HBO, Fox, AMC, Disney e molti altri (gadi.sassoon@gmail.com).